两个原则? 平移不变性和局部性

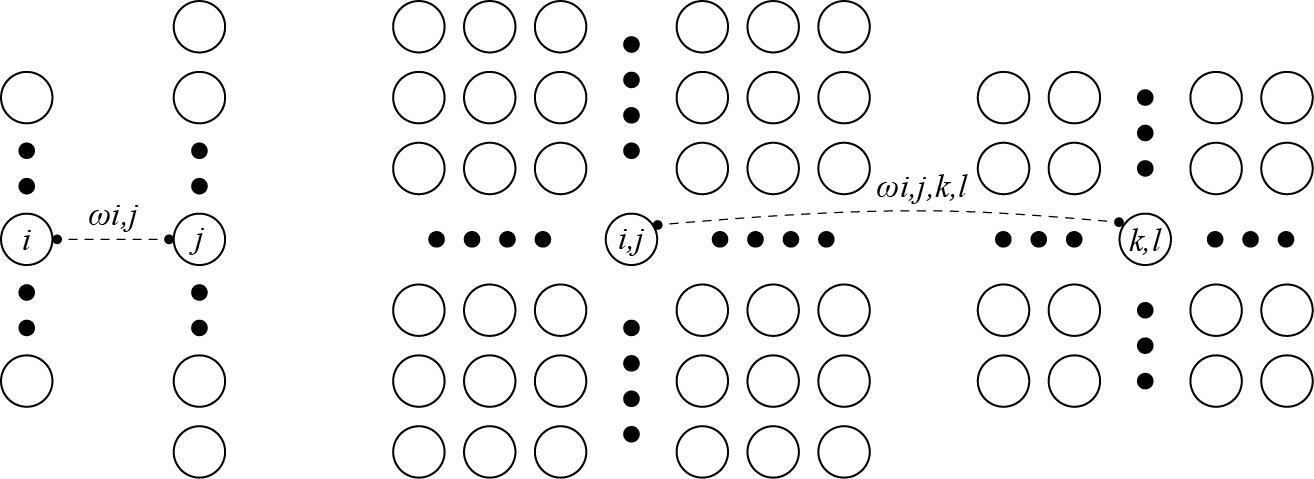

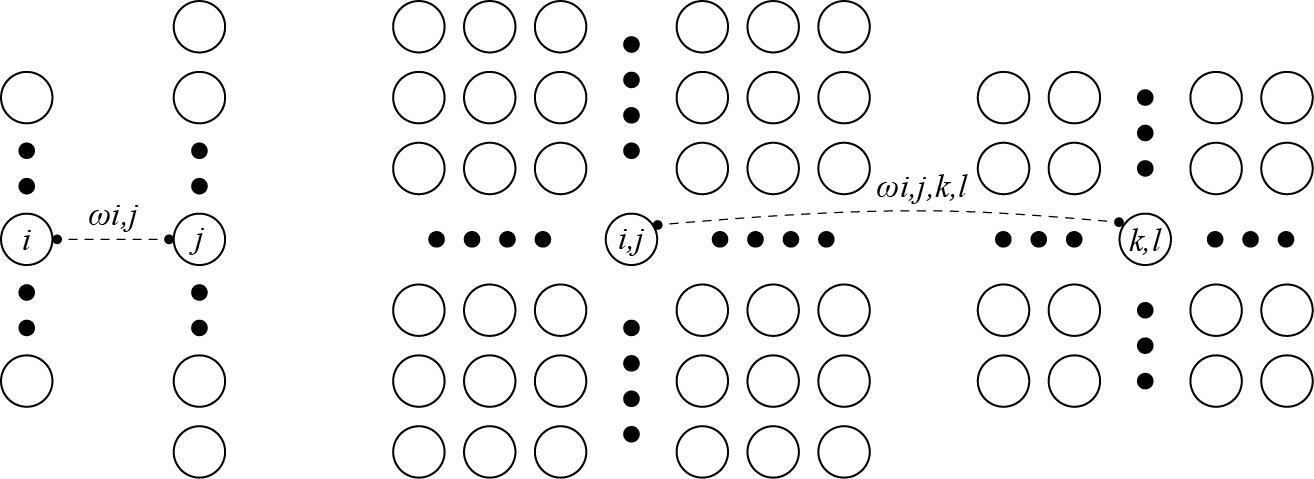

重新考察全连接层#

-

将输入和输出变形为矩阵(宽度,高度)

-

将权重变形为4-D张量(h,w)到(h′,w′)

i,j=k,l∑wi,j,k,lxk,l=a,b∑vi,j,a,bxi+a,j+b

-

v是w的重新索引vi,j,a,b=wi,j,i+a,j+b

原则 #1 - 平移不变性#

- x的平移导致h的平移hi,j=∑a,bvi,j,a,bxi+a,j+b

- v不应该依赖于(i,j)

- 解决方案:vi,j,a,b=va,b

i,j=a,b∑va,bxi+a,j+b

- 这就是2维交叉相关

原则 #2 - 局部性#

hi,j=a,b∑va,bxi+a,j+b

- 当评估hi,j时,我们不应该用远离xi,j的参数

- 解决方案:当∣a∣,∣b∣>Δ时,使得va,b=0

i,j=a=−Δ∑Δb=−Δ∑Δva,bxi+a,j+b

- 卷积层将输入和核矩阵进行交叉相关,加上偏移后得到输出

- 核矩阵和偏移时可学习的参数

- 核矩阵大小是超参数

NOTE对图像进行一次卷积操作后,输出的矩阵相较于输入的矩阵会变小。假设给定(32×32)的输入图像,应用5×5大小的卷积核:

- 第1层得到输出大小为28×28

- 第7层得到输出大小为4×4

如果用更大的卷积核,则输出矩阵的缩小会变得更快,形状会从nh×nw减少到(nh−kh+1)×(nw−kw+1)

为了解决这个缩小的问题,我们选择在输入周围添加额外的行/列

填充ph行和pw列,输出的形状为(nh−kh+ph+1)×(nw−kw+pw+1)

通常取ph=kh−1,pw=kw−1:

填充ph行和pw列,输出的形状为(nh−kh+ph+1)×(nw−kw+pw+1)

通常取ph=kh−1,pw=kw−1:

- 当kh为奇数:在上下两侧填充ph/2

- 当kh为偶数:在上侧填充⌈ph/2⌉,在下侧填充⌊ph/2⌋

填充减小的输出大小与层数线性相关,给定输入大小224×224,在使用5×5卷积核的情况下需要44层将输出降低到4×4

需要大量的计算才能得到较小输出

步幅是指行/列的滑动步长,例:高度3宽度2的步幅

当垂直步幅为sh、水平步幅为sw时,输出形状为⌊(nh−kh+ph+sh)/sh⌋×⌊(nw−kw+pw+sw)/sw⌋

如果我们设置了ph=kh−1和pw=kw−1,则输出形状将简化为

当垂直步幅为sh、水平步幅为sw时,输出形状为⌊(nh−kh+ph+sh)/sh⌋×⌊(nw−kw+pw+sw)/sw⌋

如果我们设置了ph=kh−1和pw=kw−1,则输出形状将简化为

⌊(nh+sh−1)/sh⌋×⌊(nw+sw−1)/sw⌋更进一步,如果输入的高度和宽度可以被垂直和水平步幅整除,则输出形状将为

(nh/sh)×(nw/sw)

IMPORTANT填充和步幅是卷积层的超参数

填充在输入周围添加额外的行/列,来控制输出形状的减少量

步幅是每次滑动核矩阵时的行/列步长,可以成倍地减少输出形状

填充行和列,输出的形状为

通常取,:

当垂直步幅为、水平步幅为时,输出形状为

如果我们设置了和,则输出形状将简化为